-

1 简介Hadoop是一个开源的分布式存储及计算框架,被广泛用于海量数据的存储及处理,可以以可靠、高效、可伸缩的方式进行数据处理,开发语言为Java。 2 环境信息硬件版本软件版本服务器Taishan服务器CentOS7.6CPU鲲鹏920OS kernel4.14.0-115磁盘分区无JDK1.7.0_191网络可访问外网GCC4.8.5 Maven3.5.4 Protobuf2.5.03 配置编译环境3.1安装GCC1、 挂载OS镜像将OS镜像上传至服务器/root目录下mount -o loop CentOS-7-aarch64-Everything-1810.iso /mnt2、配置yum本地源cd /etc/yum.repos.d/mkdir /bakmv * /bak3、编辑配置文件:vim local.repo内容增加如下:[local]name=localbaseurl=file:///mntenable=1gpgcheck=0 执行下面使yum源生效:yum clean allyum makecache 4、安装GCC相关软件yum -y install gcc.aarch64 gcc-c++.aarch64 gcc-gfortran.aarch64 libgcc.aarch645、解决-fsigned-char问题(修改gcc)使用command -v gcc(或者which gcc)寻找gcc所在路径更改gcc的名字(例如改成gcc-impl)mv /usr/bin/gcc /usr/bin/gcc-impl执行 vim /usr/bin/gcc填如如下内容:#!bin/sh/usr/bin/gcc-impl –fsigned-char “$@”执行如下命令给脚本添加权限chmod +x /usr/bin/gcc使用gcc --version查看版本3.2安装OpenJDK1、下载并安装到指定目录wget https://github.com/AdoptOpenJDK/openjdk8-binaries/releases/download/jdk8u252-b09/OpenJDK8U-jdk_aarch64_linux_hotspot_8u252b09.tar.gztar -zxf OpenJDK8U-jdk_aarch64_linux_hotspot_8u252b09.tar.gzmkdir -p /opt/tools/installed/mv jdk8u252-b09 /opt/tools/installed/2、配置环境变量vim /etc/profile添加如下:export JAVA_HOME=/opt/tools/installed/jdk8u252-b09export PATH=$JAVA_HOME/bin:$PATH使环境变量生效:source /etc/profile3、查看java版本java -version 3.3安装Maven1、下载并安装到指定目录(如/opt/tools/installed)wget https://archive.apache.org/dist/maven/maven-3/3.5.4/binaries/apache-maven-3.5.4-bin.tar.gztar -zxf apache-maven-3.5.4-bin.tar.gzmkdir -p /opt/tools/installed/mv apache-maven-3.5.4 /opt/tools/installed/ 2、修改环境变量vim /etc/profile添加如下内容:export MAVEN_HOME=/opt/tools/installed/apache-maven-3.5.4export PATH=$MAVEN_HOME/bin:$PATH3、使环境变量生效source /etc/profile检查配置是否生效mvn -v4、修改Maven配置文件中的本地仓路径、远程仓等。配置文件:vim /opt/tools/installed/apache-maven-3.5.4/conf/settings.xml本地仓库默认在”~/.m2/“目录下,如果想修改成指定目录,则修改localRepository标签,如果没有特殊需求,可不必修改该参数。远程仓库配置修改成如下:<mirror> <id>huaweimaven</id> <name>huawei maven</name> <url>https://mirrors.huaweicloud.com/repository/maven/</url> <mirrorOf>central</mirrorOf> </mirror> 如果不能连接外网,需要配置代理: <proxies> <proxy> <id>optional</id> <active>true</active> <protocol>http</protocol> <username>用户名</username> <password>密码</password> <host>代理服务器网址</host> <port>代理服务器端口</port> <nonProxyHosts>local.net|some.host.com</nonProxyHosts> </proxy> </proxies> 根据实际情况来配置。3.4安装cmakeHadoop编译需要3.12及以上版本,CentOS自带版本较低,需要升级。1、下载并解压安装包wget https://cmake.org/files/v3.12/cmake-3.12.4.tar.gztar -xvf cmake-3.15.2.tar.gz2、编译安装tar -xvf cmake-3.15.2.tar.gzcd cmake-3.15.2/./bootstrapmake -j8make install3.5安装protocyum install -y protobuf protobuf-devel 3.6安装SnappySnappy是一个可选的、也是很常用的压缩库,可添加编译选项打包到hadoop软件包中。安装基本库yum install openssl-devel zlib-devel automake libtool下载Snappy依赖包:wget https://github.com/google/snappy/releases/tag/1.1.7解压后进入文件夹修改txt文件开启动态链接库编译vim CMakeLists.txt将该选项从“OFF”改为“ON”:option(BUILD_SHARED_LIBS "Build shared libraries(DLLs)." ON)创建编译目录并执行编译。编译hadoopmkdir buildcd buildcmake ../make install 3.7执行移植分析1、使用devkit进行扫描分析,如有依赖需要先编译相关依赖。4 编译hadoop下载Hadoop源码包:wget https://archive.apache.org/dist/hadoop/common/hadoop-3.1.1/hadoop-3.1.1-src.tar.gz 2、解压后进入目录,修改pom.xml 添加鲲鹏maven仓库: <repository> <id>kunpengmaven</id> <name>kunpeng maven</name> <url>https://mirrors.huaweicloud.com/kunpeng/maven</url> </repository> 添加插件仓库:(pluginRepositories和repositories的节点级别一样、可能需要手动创建) <pluginRepositories> <pluginRepository> <id>huaweicloud-plugin</id> <url>http://mirrors.huaweicloud.com/repository/maven</url> <snapshots> <enabled>true</enabled> </snapshots> </pluginRepository> </pluginRepositories> 3、执行编译mvn package -DskipTests -Pdist,native -Dtar -Dsnappy.lib=/usr/local/lib64 –Dbundle.snappy -Dmaven.javadoc.skip=true 4、编译成功编译成功后,将在源码下的“hadoop-dist/target/”目录生成tar.gz包 5、检查native,支持snappy 5 FAQ:如果是OpenEuler,在使用本地yum源安装依赖的时候会有缺依赖相关报错,这是因为iso文件中缺包导致,可以使用OpenEuler的官方源进行挂载:repo.openeuler.org挂载方式与本地yum源基本相同,仅修改如下:baseuel=https://repo.openeuler.org/openEuler-20.03-LTS/everything/aarch_64 执行yum clean all yum makecahce创建完成。

-

1 前言apache-doris是apache官网的一款组件,本文旨在介绍其编译安装方法。源码下载地址:https://github.com/apache/incubator-doris/archive/0.12.0-rc03.tar.gz编译流程:http://doris.apache.org/master/zh-CN/installing/compilation.html本次使用物理机的环境直接进行部署,不在docker容器内进行2 物理机编译2.1 依赖环境准备步骤 1 源码下载。# wget https://github.com/apache/incubator-doris/archive/0.12.0-rc03.tar.gz# tar -zxvf apache-doris-0.12.0-incubating-src.tar.gz步骤 2 依赖环境提供Doris会下载约20个源码包进行编译,相应步骤在build.sh及thirdparty/*.sh中有描述,请参考具体脚本。Gcc-5.3.0+, JDK 1.8+, python 2.7+, Apache Maven 3.5+, Cmake 3.11+ //基础环境安装//# yum install -y byacc flex flex-devel libtool binutils-devel# gcc及cmake升级指导请参见华为鲲鹏社区:https://support.huaweicloud.com/prtg-kunpengdbs/kunpengmysql5727_02_0007.html# yum install -y python python-devel java-1.8.0-openjdk java-1.8.0-openjdk-devel //本次使用BClinux 7.6,自带python和java符合版本要求//# wget https://archive.apache.org/dist/maven/maven-3/3.6.0/binaries/apache-maven-3.6.0-bin.tar.gz# tar -zxvf apache-maven-3.6.0-bin.tar.gz# vim /etc/profile# echo “export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.212.b04-0.el7_6.aarch64/jre” >> /etc/profile# echo “export PATH=$JAVA_HOME/bin:/home/BY-compute/apache-maven-3.6.0/bin:/usr/local/go/bin:$PATH” >> /etc/profile# source /etc/profile步骤 3 文件修改# cd apache-doris-0.12.0-incubating-src# vim thirdparty/vars.sh修改如下地方59 LIBEVENT_DOWNLOAD="doris-thirdparty-repo.bj.bcebos.com/thirdparty/libevent-20180622-24236aed01798303745470e6c498bf606e88724a.zip"132 ZLIB_DOWNLOAD="https://github.com/madler/zlib/archive/v1.2.11.tar.gz"133 ZLIB_NAME=zlib-1.2.11.tar.gz134 ZLIB_SOURCE=zlib-1.2.11135 ZLIB_MD5SUM="0095d2d2d1f3442ce1318336637b695f"179 BOOST_DOWNLOAD="https://dl.bintray.com/boostorg/release/1.64.0/source/boost_1_64_0.tar.gz"180 BOOST_NAME=boost_1_64_0.tar.gz181 BOOST_SOURCE=boost_1_64_0182 BOOST_MD5SUM="319c6ffbbeccc366f14bb68767a6db79"192 BOOST_FOR_MYSQL_DOWNLOAD="http://sourceforge.net/projects/boost/files/boost/1.59.0/boost_1_59_0.tar.gz"194 BOOST_FOR_MYSQL_NAME=boost_1_59_0.tar.gz196 BOOST_FOR_MYSQL_SOURCE=boost_1_59_0 //实际编译的时候发现存在问题,手动替换包与md5值通过,此处不展开写//198 BOOST_FOR_MYSQL_MD5SUM="7da224395bb63c7389fce82660213c57"273 ORC_DOWNLOAD="https://archive.apache.org/dist/orc/orc-1.5.8/orc-1.5.8.tar.gz"274 ORC_NAME=orc-1.5.8.tar.gz275 ORC_SOURCE=orc-1.5.8276 ORC_MD5SUM="2318b0a8233c8833b3a6cfd771c60883"277 #ORC_DOWNLOAD="http://mirror.bit.edu.cn/apache/orc/orc-1.5.8/orc-1.5.8.tar.gz"278 #ORC_NAME=orc-1.5.8.tar.gz279 #ORC_SOURCE=orc-1.5.8280 #ORC_MD5SUM="2318b0a8233c8833b3a6cfd771c60883"# cp ../lib/libzstd.a $PATH/BY-compute/apache-doris-0.12.0-incubating-src/thirdparty/src/arrow-apache-arrow-0.15.1/cpp/release/zstd_ep-install/lib64//此处请见FAQ 5.1,为编译时缺少步骤导致,未完全修改build脚本,生动方式替代//# vim thirdparty/build-thirdparty.sh //mysql编译问题,这边解决办法比较粗糙,后续待细化//步骤 4 Maven仓修改# vim apache-maven-3.6.0/conf/settings.xml# vim apache-doris-0.12.0-incubating-src/fe/pom.xml //增加CDH的maven源//步骤 5 lz4-1.3.0及netty-all-4.1.52编译# 相应编译不在此处展开,可以查看鲲鹏社区相关文档进行编译及jar包替换# lz4-1.3.0.jar https://support.huaweicloud.com/prtg-tpdl-kunpengbds/kunpenglz4java_02_0004.html# netty-all-4.1.52.jar https://support.huaweicloud.com/prtg-tpdl-kunpengbds/kunpengnettyall4117_02_0001.html2.2 编译安装步骤 1 编译执行# ./build.sh //自动化安装,时间较长,同时出现报错请debug//# ll output //3 Docker环境编译3.1 Docker image制作步骤 1 Dockerfile在apache-doris-0.12.0-incubating-src/docker/Dockerfile中,有对应doris-dev开发环境镜像的制作,编译方法在dockerfile中写的较为详细,可以本地构建arm64的docker image进行doris编译,当前不对此场景展开编译,后续补充后增加# vim Dockerfile4 总结本文仅对doris的编译进行说明,使用情况待补充。 5 FAQ5.1 Q1 cp: cannot stat ‘./zstd_ep-install/lib/libzstd.a’: No such file or directoryQ1:build-thirdpart时,发现libzstd.a不存在,cp报错。Answer1:通过分析安装脚本,确认以下动作# vim thirdparty/build-thirdparty.sh# cd thirdparty/src/zstd-1.3.7/tests# vim Makefile# make zstd-staticLib# find / -name “libzstd.a”# mkdir -p /home/BY-compute/apache-doris-0.12.0-incubating-src/thirdparty/src/arrow-apache-arrow-0.15.1/cpp/release/zstd_ep-install/lib64# cp ../lib/libzstd.a /home/BY-compute/apache-doris-0.12.0-incubating-src/thirdparty/src/arrow-apache-arrow-0.15.1/cpp/release/zstd_ep-install/lib64

-

【功能模块】apache-kudu-1.10.0 在TaiShan 200服务器迁移【操作步骤&问题现象】1、下载kudu包2、编译,编译步骤见附件【截图信息】问题已解决,解决办法如下: 修改thirdparty/vars.sh文件,修改174行版本为“1.10.0” 修改 thirdparty/build-definitions.sh文件,注释808行$MEMKIND_BDIR/build_jemalloc.sh --disable-cxx --prefix=$PREFIX内容 修改thirdparty/download-thirdparty.sh文件,注释357到364行 手动下载memkind编译 cd /home wget https://github.com/memkind/memkind/archive/refs/tags/v1.10.0.tar.gz tar -zxvf v1.10.0.tar.gz yum install numactl-devel -y cd /home/memkind-1.10.0 ./build.sh --prefix=/usr make install ldconfig拷贝memkind到apache-kudu-1.10.0/thirdparty/src目录cp -r /home/memkind-1.10.0 /****/apache-kudu-1.10.0/thirdparty/src重新编译,问题解决【日志信息】(可选,上传日志内容或者附件)

Kongfu Panda

发表于2022-02-21 21:12:04

2022-02-21 21:12:04

最后回复

Kongfu Panda

2022-02-22 18:17:15

1368 5

Kongfu Panda

发表于2022-02-21 21:12:04

2022-02-21 21:12:04

最后回复

Kongfu Panda

2022-02-22 18:17:15

1368 5 -

【功能模块】【Apache zeppelin-0.10.0】【Zeppelin: web Application】【鲲鹏编译】【操作步骤&问题现象】0.操作环境mvn git npm 均做了代理,但不知道为什么 执行npm命令就失败了1、操作步骤mvn clean package -Pspark-2.4 -Pspark-scala-2.12 -Phadoop2 -DskipTests 2.问题现象Failed to execute goal com.github.eirslett:frontend-maven-plugin:1.6:npm (npm install) on project zeppelin-web: Failed to run task: 'npm install --no-lockfile --https-proxy=http://proxyuser:***@192.168.1.216:808 --proxy=http://proxyuser:***@192.168.1.216:808' failed. org.apache.commons.exec.ExecuteException: Process exited with an error: 1 (Exit value: 1) -> [Help 1]3、错误日志[INFO] Zeppelin: Client Examples .......................... SUCCESS [ 0.934 s][INFO] Zeppelin: web Application .......................... FAILURE [01:59 min][INFO] Zeppelin: Server ................................... SKIPPED[INFO] Zeppelin: Plugins Parent ........................... SKIPPED[INFO] Zeppelin: Plugin S3NotebookRepo .................... SKIPPED[INFO] Zeppelin: Plugin GitHubNotebookRepo ................ SKIPPED[INFO] Zeppelin: Plugin AzureNotebookRepo ................. SKIPPED[INFO] Zeppelin: Plugin GCSNotebookRepo ................... SKIPPED[INFO] Zeppelin: Plugin ZeppelinHubRepo ................... SKIPPED[INFO] Zeppelin: Plugin FileSystemNotebookRepo ............ SKIPPED[INFO] Zeppelin: Plugin MongoNotebookRepo ................. SKIPPED[INFO] Zeppelin: Plugin OSSNotebookRepo ................... SKIPPED[INFO] Zeppelin: Plugin Kubernetes StandardLauncher ....... SKIPPED[INFO] Zeppelin: Plugin Flink Launcher .................... SKIPPED[INFO] Zeppelin: Plugin Docker Launcher ................... SKIPPED[INFO] Zeppelin: Plugin Cluster Launcher .................. SKIPPED[INFO] Zeppelin: Plugin Yarn Launcher ..................... SKIPPED[INFO] Zeppelin: Packaging distribution ................... SKIPPED[INFO] ------------------------------------------------------------------------[INFO] BUILD FAILURE[INFO] ------------------------------------------------------------------------[INFO] Total time: 16:36 min[INFO] Finished at: 2022-01-17T17:37:40+08:00[INFO] ------------------------------------------------------------------------[ERROR] Failed to execute goal com.github.eirslett:frontend-maven-plugin:1.6:npm (npm install) on project zeppelin-web: Failed to run task: 'npm install --no-lockfile --https-proxy=http://proxyuser:***@192.168.1.216:808 --proxy=http://proxyuser:***@192.168.1.216:808' failed. org.apache.commons.exec.ExecuteException: Process exited with an error: 1 (Exit value: 1) -> [Help 1][ERROR] [ERROR] To see the full stack trace of the errors, re-run Maven with the -e switch.[ERROR] Re-run Maven using the -X switch to enable full debug logging.[ERROR] [ERROR] For more information about the errors and possible solutions, please read the following articles:[ERROR] [Help 1] http://cwiki.apache.org/confluence/display/MAVEN/MojoFailureException[ERROR] [ERROR] After correcting the problems, you can resume the build with the command[ERROR] mvn <args> -rf :zeppelin-web【截图信息】【日志信息】(可选,上传日志内容或者附件)

-

漏洞名称 : Apache Dubbo Hessian-Lite 反序列化漏洞组件名称 : Apache Dubbo Hessian-Lite影响范围:Apache Dubbo 2.6.x < 2.6.12Apache Dubbo 2.7.x < 2.7.15Apache Dubbo 3.0.x < 3.0.5漏洞类型:反序列化利用条件:1、用户认证:未知2、前置条件:未知3、触发方式:远程综合评价:<综合评定利用难度>:未知。<综合评定威胁等级>:高危,能造成远程代码执行。漏洞分析:1、组件介绍Apache Dubbo 是一款高性能、轻量级的开源 java Rpc 分布式服务框架。核心功能有面向接口的远程过程调用、集群容错和负载均衡、服务自动注册与发现。其特点主要在以下几个方面。使用分层的架构模式,使得各个层次之间实现最大限度的解耦。将服务抽象为服务提供者与服务消费者两个角色。2、漏洞描述近日,监测到一则 Apache Dubbo 组件存在反序列化漏洞的信息,漏洞编号:CVE-2021-43297,漏洞威胁等级:高危。该漏洞是由于 Apache Dubbo 在反序列化数据出现异常时 Hessian 会记录用户的信息,攻击者可以构造恶意数据,最终导致远程代码执行,获取服务器最高权限。影响范围:Apache Dubbo 作为一款高性能、轻量级的开源 Java 服务框架,当前可能受漏洞影响的资产广泛分布于世界各地,国内主要集中在广东、江苏、河北等省份地区。目前受影响的 Apache Dubbo 版本:Apache Dubbo 2.6.x < 2.6.12Apache Dubbo 2.7.x < 2.7.15Apache Dubbo 3.0.x < 3.0.5解决方案:1 、如何检测组件版本方案一全盘搜索dubbo,如果存在dubbo-{version}.jar则用户可能受漏洞影响。方案二如果项目是由maven编译的(一般在项目根目录下会有pom.xml)打开pom.xml文件,:在此文件中搜索dubbo,如果可以搜索到关键字,并且<version>标签内部的字段在:2.6.0版本及以上并且小于2.16.12或2.7.0版本及以上并且小于2.7.15或3.0.0版本及以上并且小于3.0.5,则可能受到漏洞的影响。(图中的dubbo的版本是2.7.13,在漏洞影响范围内)如以上检索均未发现结果,不能够完全下结论一定没有使用 dubbo 组件 ,建议联系开发人员进一步核实。2、官方修复建议当前官方已发布最新版本,建议受影响的用户及时更新升级到最新版本。链接如下:https://dubbo.apache.org/en/blog/2020/05/18/past-releases/参考链接:https://lists.apache.org/thread/1mszxrvp90y01xob56yp002939c7hlww

-

新的一年,茁壮成长的社区迎来了越来越多志同道合的伙伴。通过PMC们新一轮的推荐和投票,Apache IoTDB社区新增1位来自东方国信的PMC和4位来自阿里云、华为、360、云智慧等公司的Committer。01 PMC 戚厚亮硕士毕业于中国科学院计算技术研究所,前百度搜索架构部高级研发工程师,后加入东方国信担任时序数据库架构师,主导时序数据库高可用、分布式设计以及在东方国信工业场景的落地。对微服务,分布式存储,高可用等领域比较感兴趣。和Apache IoTDB的故事2020年4月初识IoTDB,那时候IoTDB还是Apache孵化项目,其单机性能已经非常优越,但是社区一直没有分布式版本,考虑到以后随着接入设备越来越多,数据量越来越大以及对高可用的需求,分布式势在必行,所以就加入到了分布式版本的研发中,从单机到分布式不是一蹴而就的,过程中遇到了很多的问题。很庆幸,与社区里面志同道合的小伙伴们一起,在2021年4月份的时候,社区发布了第一个分布式版本。IoTDB是从清华大学实验室出来的一个工业级产品,非常佩服这帮人的情怀,看着社区越来越强大,使用IoTDB的项目也越来越多,也感到很开心,国人主导的数据库基础软件正在大放异彩,很庆幸能够在这个过程中贡献自己的小小力量。对Apache IoTDB的贡献提交PR 100多个,主要包括修复Raft一致性协议的Bug以增强Raft协议正确性、使一些工作异步化来提高Raft框架的性能、剥离数据服务和心跳服务、Raft日志持久化、支持Thrift RPC 大小可自动调节、支持读取数据三种一致性,以及很多单机Plan的分布式实现、支持跨时间分区加载文件等工作。并且针对一些用户的疑问进行解答,推广IoTDB等。对Apache IoTDB的寄语期待IoTDB能够在更多的场景中落地!02 Committer 白渐来自阿里云和Apache IoTDB的故事机缘巧合下,经过黄老师的推荐以及孙金城老师的认可,成为阿里云物联网分析团队的一员,并能够同时以社区贡献者的身份,从事 IoTDB 的相关工作。在这里我学到了如何将一个基础系统做精,如何将一个开源系统做大,并通过自己的行动回馈社区、帮助社区内的其他同学。十分荣幸能够成为 IoTDB 的 Committer。对Apache IoTDB的贡献UDF 聚合计算嵌套功能设计开发;集群稳定性提高;集群优化与功能问题修复。对Apache IoTDB的寄语希望 IoTDB 能够成长为物联网云边一体领域 No.1 的数据库,成为国产基础软件的标杆。03 Committer 宋秉华来自华为云对Apache IoTDB的贡献与清华王建民院长一起在华为云techwave宣讲IoTDB产品特性及其在华为的应用。在华为云撰写《MRS IoTDB时序数据库的整体架构设计与实现》文章并被多家媒体转载。参与IoTDB开源社区分布式系统重构设计讨论和发布相关Issue。参与IoTDB开源社区Continuous Query、Thrift协议升级等特性开发。组织内部团队向IoTDB开源社区贡献数十个PR和BUG修复。对Apache IoTDB的寄语期望IoTDB成为国产基础工业软件的明珠。04 Committer 程建云就职于360 大数据开发岗位,主要负责中台时序数据库的产品开发与落地。毕业于哈尔滨工业大学,曾供职微软中国,主要负责参与了Bing 词典、Cortana等产品开发。对Apache IoTDB的寄语Apache IoTDB是最适合存储与分析物联网场景大数据的产品,会在未来物联网中扮演越来越重要的角色。05 Committer 苗红闪我来自云智慧智能研究院算法团队,主要负责指标数据的存储和研发工作。我们这边日常处理超过千万级的指标数据。数据体量大、乱序到达、缺失丢点、峰谷潮、粒度不齐整、重复采集等问题在运维场景非常突出,这也是我首次接触IoTDB后被吸引并持续为其贡献的原因。最终,我也非常荣幸成为IoTDB的committer。和Apache IoTDB的故事我们研究院一直在帮助公司打造以数据为基础,以场景为向导,以算法为支撑的面向IT运维监控、运维服务管理、IT运维可视化的一体化综合运维管理平台。而运维平台离不开海量的指标数据的存储和处理。2021年9月,我们首次将IoTDB引入到我们算法产品当中以替代原先的clickhouse存储方案,事实证明,IoTDB在吞吐能力、自动纠错能力上有无可比拟的优势,完美解决了我们对指标数据的存储需求。对Apache IoTDB的贡献目前主要负责Apache IoTDB的 REST Service、grafana plugin模块开发和jdbc模块的完善等工作。对Apache IoTDB的寄语很荣幸能够成为Apache IoTDB项目的commiter非常感谢社区对我的认可。在社区里认识了好多优秀的小伙伴,希望更多志同道合的小伙伴加入进来,一起让Apache IoTDB的性能越来越强大,生态也越来越完善。关于我们Apache IoTDB 是一个开源物联网时序数据库管理系统,旨在满足大规模物联网和工业物联网(IoT 和 IIoT)应用对数据、存储和分析的严苛要求。据不完全统计,目前已有三十家以上的用户进行测试与使用,包括联想、海尔、中车四方、大唐先一、湖南中烟、美国安赛乐米塔尔、德国Pragmatic minds、商飞等等。IoTDB相关文章华为云FusionInsight携手国家级大数据实验室,探索时序数据库IoTDBhttps://bbs.huaweicloud.com/blogs/289305 文章转载自Apache IoTDB公众号 https://mp.weixin.qq.com/s/9Bqyfho9tESUDsAMJOm3ZQ免责声明:转载文章版权归原作者所有。如涉及作品内容、版权等问题,请及时联系文章编辑!

-

【背景】Logstash-OSS受Apache Log4j2远程代码影响:https://discuss.elastic.co/t/apache-log4j2-remote-code-execution-rce-vulnerability-cve-2021-44228-esa-2021-31/291476,需要由7.10.1版本升级至解决问题版本7.16.2【问题】logstash.conf:output { elasticsearch{ hosts => ["https://10.33.27.xxx:9200","https://10.33.27.xxy:9200","https://10.33.27.xxz:9200"] user => "admin" password => "xxxxx" cacert => "xxxxx" ilm_enabled => false index => "xxxx-%{+YYYY.MM.dd}" manage_template => true template_overwrite => true template_name => "xxxx_template" }}华为云CSS服务版本为ElasticSearch 7.6.2版本,升级Logstash-OSS版本至7.16.2后,启动失败:[2021-12-27T09:44:20,042][ERROR][logstash.javapipeline][main]Pipelineerror{:pipeline_id=>"main",:exception=>#<LogStash::ConfigurationError:CouldnotconnecttoacompatibleversionofElasticsearch>,:backtrace=>["/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-Elasticsearch-11.2.3-java/lib/logstash/outputs/Elasticsearch/http_client/pool.rb:247:in blockinhealthcheck!'","org/jruby/RubyHash.java:1415:in each'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-Elasticsearch-11.2.3-java/lib/logstash/outputs/Elasticsearch/http_client/pool.rb:240:in healthcheck!'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-elasticsearch-11.2.3-java/lib/logstash/outputs/elasticsearch/http_client/pool.rb:374:in update_urls'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-Elasticsearch-11.2.3-java/lib/logstash/outputs/Elasticsearch/http_client/pool.rb:89:in update_initial_urls'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-elasticsearch-11.2.3-java/lib/logstash/outputs/elasticsearch/http_client/pool.rb:83:in start'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-Elasticsearch-11.2.3-java/lib/logstash/outputs/Elasticsearch/http_client.rb:359:in build_pool'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-elasticsearch-11.2.3-java/lib/logstash/outputs/elasticsearch/http_client.rb:63:in initialize'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-Elasticsearch-11.2.3-java/lib/logstash/outputs/Elasticsearch/http_client_builder.rb:106:in create_http_client'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-elasticsearch-11.2.3-java/lib/logstash/outputs/elasticsearch/http_client_builder.rb:102:in build'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-Elasticsearch-11.2.3-java/lib/logstash/plugin_mixins/Elasticsearch/common.rb:34:in build_client'","/home/test/logstash/vendor/bundle/jruby/2.5.0/gems/logstash-output-elasticsearch-11.2.3-java/lib/logstash/outputs/elasticsearch.rb:275:in register'","org/logstash/config/ir/compiler/OutputStrategyExt.java:131:in register'","org/logstash/config/ir/compiler/AbstractOutputDelegatorExt.java:68:in register'","/home/test/logstash/logstash-core/lib/logstash/java_pipeline.rb:232:in blockinregister_plugins'","org/jruby/RubyArray.java:1821:in each'","/home/test/logstash/logstash-core/lib/logstash/java_pipeline.rb:231:in register_plugins'","/home/test/logstash/logstash-core/lib/logstash/java_pipeline.rb:589:in maybe_setup_out_plugins'","/home/test/logstash/logstash-core/lib/logstash/java_pipeline.rb:244:in start_workers'","/home/test/logstash/logstash-core/lib/logstash/java_pipeline.rb:189:in run'","/home/test/logstash/logstash-core/lib/logstash/java_pipeline.rb:141:in`blockinstart'"],"pipeline.sources"=>["/home/test/conf/logstash.conf"],:thread=>"#<Thread:0x3a3c3828run>"}[2021-12-27T09:44:20,053][INFO][logstash.javapipeline][main]Pipelineterminated{"pipeline.id"=>"main"}[2021-12-27T09:44:20,078][ERROR][logstash.agent]Failedtoexecuteaction{:id=>:main,:action_type=>LogStash::ConvergeResult::FailedAction,:message=>"Couldnotexecuteaction:PipelineAction::Create,action_result:false",:backtrace=>nil}[2021-12-27T09:44:20,188][INFO][logstash.runner]Logstashshutdown.[2021-12-27T09:44:20,201][FATAL][org.logstash.Logstash]Logstashstoppedprocessingbecauseofanerror:(SystemExit)exitorg.jruby.exceptions.SystemExit:(SystemExit)exitatorg.jruby.RubyKernel.exit(org/jruby/RubyKernel.java:747)~[jruby-complete-9.2.20.1.jar:?]atorg.jruby.RubyKernel.exit(org/jruby/RubyKernel.java:710)~[jruby-complete-9.2.20.1.jar:?]athome.test.logstash.lib.bootstrap.environment.(/home/test/logstash/lib/bootstrap/environment.rb:94)~[?:?]官方ReleaseNode:https://www.elastic.co/guide/en/logstash/7.16/logstash-7-13-0.html从7.11版本开始,ES不再提供ElasticSearch-OSS版本:https://github.com/logstash-plugins/logstash-output-elasticsearch/pull/1005Logstash-OSS从7.13.0开始,检查ES license,不再支持对接ElasticSearch-OSS版本,故Logstash-OSS升级至7.16.2后对接失败【解决方案】OpenSearch:https://opensearch.org/OpenSearch is a community-driven, open source search and analytics suite derived from Apache 2.0 licensed Elasticsearch 7.10.2 & Kibana 7.10.2. It consists of a search engine daemon, OpenSearch, and a visualization and user interface, OpenSearch Dashboards. OpenSearch enables people to easily ingest, secure, search, aggregate, view, and analyze data. These capabilities are popular for use cases such as application search, log analytics, and more. With OpenSearch people benefit from having an open source product they can use, modify, extend, monetize, and resell how they want. At the same time, OpenSearch will continue to provide a secure, high-quality search and analytics suite with a rich roadmap of new and innovative functionality.OpenSearch提供Logstash OSS with OpenSearch Ouput Plugin:https://opensearch.org/downloads.html对应Logstash-OSS官方版本+logstash plugin(logstash-output-opensearch:https://github.com/opensearch-project/logstash-output-opensearch)二次打包:https://github.com/opensearch-project/logstash-output-opensearch/blob/main/release/tar/generate-artifact.sh从OpenSearch官方下载:https://artifacts.opensearch.org/logstash/logstash-oss-with-opensearch-output-plugin-7.16.2-linux-x64.tar.gz,或者通过logstash-plugin安装logstash-ouput-opensearch插件。修改logstash.conf:output { opensearch{ hosts => ["https://10.33.27.xxx:9200","https://10.33.27.xxy:9200","https://10.33.27.xxz:9200"] user => "admin" password => "xxxxx" cacert => "xxxxx" index => "xxxx-%{+YYYY.MM.dd}" manage_template => true template_overwrite => true template_name => "xxxx_template" }}启动成功:

-

Apache Log4j正式发布Apache Log4j 2.17.0,该版本重点解决当前曝光的三个漏洞,分别是安全漏洞CVE-2021-45105、安全漏洞CVE-2021-45046、安全漏洞CVE-2021-44228、除此以外还带来了一些新功能,如API与实现分开,这样,开发人员就可以清楚地知晓使用了哪些类和方法,该功能也实现了向前兼容,Log4j团队将以安全且兼容的方式改进实现。此外还支持多种API,添加对对 Log4j 1.2、SLF4J、Commons Logging 和 java.util.logging (JUL) API 的支持。

-

Apache官方发布安全通告,披露了Apache HTTP Server存在缓冲区溢出及SSRF漏洞,漏洞编号CVE-2021-44790、CVE-2021-44224。可导致SSRF等危害。为避免您的业务受影响,建议您及时开展安全自查,如在受影响范围,请您及时进行更新修复,避免被外部攻击者入侵。漏洞详情:Apache HTTP Server(简称Apache),是Apache软件基金会的一个开放源代码的网页服务器,可以在大多数电脑操作系统中运行,由于其具有的跨平台性和安全性,被广泛使用,是最流行的Web服务器端软件之一。CVE-2021-44224(SSRF 漏洞):如果httpd 配置作为转发代理(ProxyRequests on) ,可允许攻击者通过精心构造的 URI ,导致崩溃(空指针取消引用),或者如果httpd的配置为混合转发和反向代理声明,可以允许攻击者将请求发送到声明的 Unix 域套接字端点,造成服务器端请求伪造。CVE-2021-44790(缓冲区溢出漏洞):攻击者可通过精心构造的请求正文可能会导致 mod_lua 多部分解析器(从 Lua 脚本调用的 r:parsebody())缓冲区溢出.但Apache httpd 团队认为该漏洞较难利用。风险等级:高风险漏洞风险:攻击者可利用该漏洞导致服务器端请求伪造影响版本:CVE-2021-44224:Apache HTTP Server >=2.4.7, <=2.4.51CVE-2021-44790:Apache HTTP Server <=2.4.51安全版本:Apache HTTP Server >= 2.4.52修复建议:官方已发布漏洞补丁及修复版本,请评估业务是否受影响后,酌情升级至安全版本【备注】:建议您在升级前做好数据备份工作,避免出现意外漏洞参考:https://httpd.apache.org/security/vulnerabilities_24.html

-

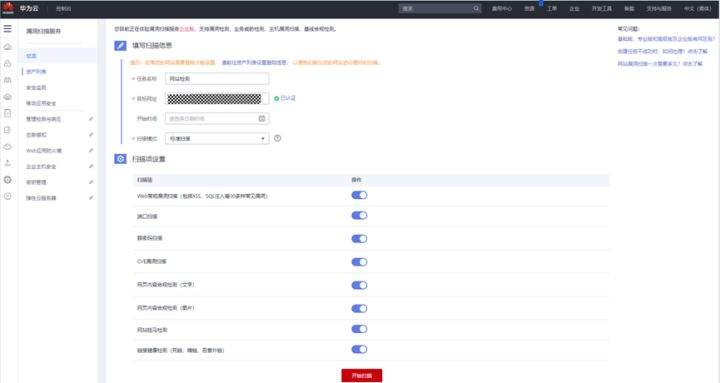

本文分享自华为云开发者社区[《Apache Log4j2远程代码执行漏洞攻击,华为云安全支持检测拦截》](https://blog.csdn.net/devcloud/article/details/121878820?spm=1001.2014.3001.5501),作者:华为助力企业上云。 近日,华为云安全团队关注到Apache Log4j2 的远程代码执行最新漏洞。Apache Log4j2是一款业界广泛使用的基于Java的日志工具,该组件使用范围广泛,利用门槛低,漏洞危害极大。华为云安全在第一时间检测到漏洞状况并在官网发布相关公告,在此提醒使用Apache Log4j2的用户尽快安排自检并做好安全防护。 **公告详情:** [Apache Log4j2 远程代码执行漏洞_华为云](https://www.huaweicloud.com/notice/2021/20211210001621800.html) Apache Log4j2是一款业界广泛使用的基于Java的日志记录工具。此次曝出的漏洞,利用门槛低,漏洞危害极大,威胁级别定义为严重级。此漏洞存在于Apache Log4j 2.x到 2.15.0-rc1多个版本,已知受影响的应用及组件包括spring-boot-starter-log4j2 / Apache Solr / Apache Flink / Apache Druid等。 华为云安全在第一时间提供了对该漏洞的防护。仅仅过去数小时,华为云WAF就在现网中拦截了Apache Log4j2 远程代码执行漏洞的大量变形攻击,通过分析发现攻击者正在不断尝试新的攻击方法,当前已识别到10+种试图取得服务器控制权的变形攻击。鉴于此漏洞威胁级别高,而且出现大量变形攻击,因此华为云安全团队提醒客户及时采取处置措施和开启防护服务。 # 一、漏洞处置: 1. 尽快升级至Apache log4j-2.15.0-rc2官方正式版,Apache官方已发布补丁,下载地址:https://github.com/apache/logging-log4j2/releases/tag/log4j-2.15.0-rc2 2. 对于无法短时间升级新版本的情况,建议采取如下措施来缓解: - (优先) 添加以下JVM启动参数来禁止解析JDNI,重启服务,jvm参数 -Dlog4j2.formatMsgNoLookups=true - log4j2.ini 配置中设置log4j2.formatMsgNoLookups=True 禁止解析JDNI - 系统环境变量 FORMAT_MESSAGES_PATTERN_DISABLE_LOOKUPS 设置为true - 确保使用高版本JDK,如JDK8u191默认限制远程加载恶意类(只能增加漏洞利用难度,不能杜绝) - 禁止没有必要的业务访问外网 # 二、开启防护服务,主动检测和动态防护 华为云安全持续监测此漏洞及其变种攻击,建议开启相关安全防护服务,主动扫描防护利用此漏洞进行的恶意攻击 1、开启华为云WAF的基础防护功能(购买WAF标准版、专业版或铂金版),检测和拦截各种变形攻击。 **产品页:** [Web应用防火墙WAF_云防火墙_云WAF租用_购买-华为云](https://www.huaweicloud.com/product/waf.html) 在华为云WAF控制台,防护策略->Web基础防护,开启状态,设置拦截模式,开启华为云WAF的Web基础防护功能。  2、开启华为云CFW的基础防御功能(基础版),检测和拦截各种变形攻击。 **产品页:** [防火墙 CFW-华为云](https://www.huaweicloud.com/product/cfw.html) 在华为云CFW控制台,入侵防御->防御策略设置页面,打开基础防御功能开关,并启动拦截模式。  3、华为云漏洞扫描服务VSS第一时间提供了对该漏洞的检测能力。开启华为云VSS的漏洞扫描功能(免费开通基础版,或购买专业版、高级版、企业版),检测网站及主机资产是否存在该漏洞,主动识别安全风险。 **产品页:** https://www.huaweicloud.com/product/vss.html 在华为云VSS控制台,资产列表->网站->新增域名,资产列表->主机->添加主机,启动扫描,等待任务结束,查看扫描报告。

-

【问题来源】【必填】 星网 【问题简要】【必填】java版本漏洞【问题类别】【必填】 aicc【AICC解决方案版本】【必填】 aicc8.141【期望解决时间】【选填】尽快【问题现象描述】【必填】 用户提出了一个Apache Log4j远程代码执行漏洞的问题,Apache log4j 2.2.0至2.14.1版本都会有影响,解决方法为升级至Apache Log4j 2所有相关应用到最新的 log4j-2.15.0-rc1 版本,不知道aicc使用java有没有关联这个东西,如果使用是否版本已经没有这个漏洞 【日志或错误截图】【可选】

-

前言随着云数仓技术的不断成熟,数据湖俨然已成为当下最热门的技术之一,而 Apache Hudi 是当下最具竞争力的数据湖格式之一:拥有最活跃的开源社区之一,周活跃 PR 一直维持在 50+ 水平;拥有最活跃的国内用户群之一,目前的 Apache Hudi 钉钉群用户已超过 2200+,国内各大厂商都已经布局 Apache Hudi 生态。Apache Hudi 的活跃度得益于其出色的 file format 设计和丰富的事物语义支持:类 LSM 的 file format 布局很好的适配了近实时更新场景,解决了超大数据集更新的痛点;Hudi 的事物层语义在目前的湖存储中是极其成熟和丰富的,基本所有的数据治理都可以自动化完成:compaction、rollback、cleaning、clustering。Flink On HudiApache Hudi 的 table format 对流计算友好的特性使得 Flink On Hudi 成为 Apache Hudi 项目最值得探索和挖掘的方向之一,Flink 不仅为 Hudi 解锁了超大数据流的实时更新能力、更添加了流式消费和计算的能力,让端到端近实时 ETL 得以在低成本的文件存储上轻松实现。Flink On Hudi 项目在 2020 年 11 月立项,至今已迭代了三个版本,从第一个版本开始人气和活跃度就一直高涨。5 月份组建的 Apache Hudi 钉钉群截止目前半年的时间,已经有超过 2200+ 用户,并且活跃度一直排在 Flink 用户群的前列。Flink On Hudi 已成为部署 Apache Hudi 项目的首选方案,国内主要云厂商:阿里云、华为云、腾讯云,国外的 AWS 都已集成 Flink On Hudi;国内的大型互联网公司:头条、快手、B站 以及传统企业:顺丰、海康等均有 Flink On Hudi 的生产实践,具钉钉群的跟踪回访等不完全统计,至少超过 50+ 国内公司在生产上使用 Flink On Hudi,Uber 公司更将 Flink On Hudi 作为 2022 年的重点方向在推进 !Flink On Hudi 的开发者生态也非常活跃,目前国内有阿里云、华为云、头条、B站的同学持续贡献,Uber 公司和 AWS 更专门投入人力来对接 Flink On Hudi。版本 Highlights0.10.0 版本经过社区用户的千锤百炼,贡献了多项重要的 fix,更有核心读写能力的大幅增强,解锁了多个新场景,Flink On Hudi 侧的更新重点梳理如下:Bug 修复修复对象存储上极端 case 流读数据丢失的问题 [HUDI-2548];修复全量+增量同步偶发的数据重复 [HUDI-2686];修复 changelog 模式下无法正确处理 DELETE 消息 [HUDI-2798];修复在线压缩的内存泄漏问题 [HUDI-2715]。新特性支持增量读取;支持 batch 更新;新增 Append 模式写入,同时支持小文件合并;支持 metadata table。功能增强写入性能大幅提升:优化写入内存、优化了小文件策略(更加均衡,无碎片文件)、优化了 write task 和 coordinator 的交互;流读语义增强:新增参数 earliest,提升从最早消费性能、支持参数跳过压缩读取,解决读取重复问题;在线压缩策略增强:新增 eager failover + rollback,压缩顺序改为从最早开始;优化事件顺序语义:支持处理序,支持事件序自动推导。下面挑一些重点内容为大家详细介绍:小文件优化Flink On Hudi 写入流程大致分为以下几个组件:row data to hoodie:负责将 table 的数据结构转成 HoodieRecord;bucket assigner:负责新的文件 bucket (file group) 分配;write task:负责将数据写入文件存储;coordinator:负责写 trasaction 的发起和 commit;cleaner:负责数据清理。其中的 bucket assigner 负责了文件 file group 的分配,也是小文件分配策略的核心组件。0.10.0 版本的每个 bucket assign task 持有一个 bucket assigner,每个 bucket assigner 独立管理自己的一组 file group 分组:在写入 INSERT 数据的时候,bucket assigner 会扫描文件视图,查看当前管理的 file group 中哪些属于小文件范畴,如果 file group 被判定为小文件,则会继续追加写入。比如上图中 task-1 会继续往 FG-1、FG-2 中追加 80MB 和 60MB 的数据。为了避免过度的写放大,当可写入的 buffer 过小时会忽略,比如上图中 FG-3、FG-4、FG-5 虽然是小文件,但是不会往文件中追加写。task-2 会新开一个 file group 写入。全局文件视图0.10.0 版本将原本 write task 端的文件视图统一挪到 JobManager,JobManager 启动之后会使用 Javaline 本地启动一个 web server,提供全局文件视图的访问代理。Write task 通过发送 http 请求和 web server 交互,拿到当前写入的 file group 视图。Web server 避免了重复的文件系统视图加载,极大的节省了内存开销。流读能力增强0.10.0 版本新增了从最早消费数据的参数,通过指定 read.start-commit 为 earliest 即可流读全量 + 增量数据,值得一提的是,当从 earliest 开始消费时,第一次的 file split 抓取会走直接扫描文件视图的方式,在开启 metadata table 功能后,文件的扫描效率会大幅度提升;之后的增量读取部分会扫描增量的 metadata,以便快速轻量地获取增量的文件讯息。新增处理顺序Apache Hudi 的消息合并大体分为两块:增量数据内部合并、历史数据和增量数据合并。消息之间合并通过 write.precombine.field 字段来判断版本新旧,如下图中标注蓝色方块的消息为合并后被选中的消息。0.10.0 版本可以不指定 write.precombine.field 字段,此时使用处理顺序:即后来的消息比较新,对应上图紫色部分被选中的消息。Metadata TableMetadata table 是 0.7.0 Hudi 引入的功能,目的是在查询端减少 DFS 的访问,类似于文件 listings 和 partitions 信息直接通过 metadata table 查询获取。Metadata 在 0.10.0 版本得到大幅加强,Flink 端也支持了 该功能。新版的 metadata table 为同步更新模型,当完成一次成功的数据写入之后,coordinator 会先同步抽取文件列表、partiiton 列表等信息写入 metadata table 然后再写 event log 到 timeline (即 metadata 文件)。Metadata table 的基本文件格式为 avro log,avro log 中的文件编码区别于正常的 MOR data log 文件,是由高效的 HFile data block 构成,这样做的好处是自持更高效率的 kv 查找。同时 metadata table 的 avro log 支持直接压缩成 HFile 文件,进一步优化查询效率。总结和展望在短短的半年时间,Flink On Hudi 至今已积攒了数量庞大的用户群体。积极的用户反馈和丰富的用户场景不断打磨 Flink On Hudi 的易用性和成熟度,使得 Flink On Hudi 项目以非常高效的形式快速迭代。通过和头部公司如头条、B 站等共建的形式,Flink On Hudi 形成了非常良性的开发者用户群。Flink On Hudi 是 Apache Hudi 社区接下来两个大版本主要的发力方向,在未来规划中,主要有三点:完善端到端 streaming ETL 场景 支持原生的 change log、支持维表查询、支持更轻量的去重场景;Streaming 查询优化 record-level 索引,二级索引,独立的文件索引;Batch 查询优化 z-ordering、data skipping。文章转载自Apache Flink公众号 https://mp.weixin.qq.com/s/q_yqa4jTmEHHoItp1V5Vgg免责声明:转载文章版权归原作者所有。如涉及作品内容、版权等问题,请及时联系文章编辑!

-

近日,华为云安全团队关注到Apache Log4j2 的远程代码执行最新漏洞。Apache Log4j2是一款业界广泛使用的基于Java的日志工具,该组件使用范围广泛,利用门槛低,漏洞危害极大。华为云安全在第一时间检测到漏洞状况并在官网发布相关公告,在此提醒使用Apache Log4j2的用户尽快安排自检并做好安全防护。公告详情: https://www.huaweicloud.com/notice/2021/20211210001621800.html 扫码查看Apache Log4j2是一款业界广泛使用的基于Java的日志记录工具。此次曝出的漏洞,利用门槛低,漏洞危害极大,威胁级别定义为严重级。此漏洞存在于Apache Log4j 2.x到 2.15.0-rc1多个版本,已知受影响的应用及组件包括spring-boot-starter-log4j2 / Apache Solr / Apache Flink / Apache Druid等。华为云安全在第一时间提供了对该漏洞的防护。仅仅过去数小时,华为云WAF就在现网中拦截了Apache Log4j2 远程代码执行漏洞的大量变形攻击,通过分析发现攻击者正在不断尝试新的攻击方法,当前已识别到10+种试图取得服务器控制权的变形攻击。鉴于此漏洞威胁级别高,而且出现大量变形攻击,因此华为云安全团队提醒客户及时进行检测、采取处置措施和开启防护服务。漏洞处置1. 尽快升级至Apache log4j-2.15.0-rc2官方正式版,Apache官方已发布补丁,下载地址:https://github.com/apache/logging-log4j2/releases/tag/log4j-2.15.0-rc2 2. 对于无法短时间升级新版本的情况,建议采取如下措施来缓解: (优先) 添加以下JVM启动参数来禁止解析JDNI,重启服务,jvm参数 -Dlog4j2.formatMsgNoLookups=truelog4j2配置中设置log4j2.formatMsgNoLookups=True 禁止解析JDNI系统环境变量 FORMAT_MESSAGES_PATTERN_DISABLE_LOOKUPS 设置为true确保使用高版本JDK,如JDK8u191默认限制远程加载恶意类(只能增加漏洞利用难度,不能杜绝)禁止没有必要的业务访问外网开启防护服务,主动检测和动态防护华为云安全持续监测此漏洞及其变种攻击,建议开启相关安全防护服务,主动扫描防护利用此漏洞进行的恶意攻击:1. 开启华为云WAF的基础防护功能(WAF标准版、专业版或铂金版),检测和拦截各种变形攻击,您可免费申请1个月标准版试用。产品页: https://www.huaweicloud.com/product/waf.html 扫码进入产品页在华为云WAF控制台,防护策略->Web基础防护,开启状态,设置拦截模式,开启华为云WAF的Web基础防护功能。2. 开启华为云CFW的基础防御功能(基础版),检测和拦截各种变形攻击。产品页: https://www.huaweicloud.com/product/cfw.html 扫码进入产品页在华为云CFW控制台,入侵防御->防御策略设置页面,打开基础防御功能开关,并启动拦截模式。3、华为云漏洞扫描服务VSS第一时间提供了对该漏洞的检测能力。开启华为云VSS的漏洞扫描功能(免费开通基础版,或购买专业版、高级版、企业版),检测网站及主机资产是否存在该漏洞,主动识别安全风险。产品页: https://www.huaweicloud.com/product/vss.html 扫码进入产品页在华为云VSS控制台,资产列表->网站->新增域名,资产列表->主机->添加主机,启动扫描,等待任务结束,查看扫描报告。华为云安全继承华为30多年的安全积累,华为云构筑的原生冰山安全体系和责任共担模型,为客户提供可信、极简、智能的云安全平台和服务,服务于包括华为流程与IT,消费者云及政企、电商、金融、互联网等行业客户。【卓越能力】20+自主研发的云安全服务和300+伙伴安全服务,从保护云工作负载,保护应用服务,保护数据资产,管理安全态势到帮助合规上云方面,帮助客户构建立体云安全防护。【全球合规】全球累计获得100+安全合规认证,如PCI 3DS,TISAX,ISO 27799, ISO/IEC 27701,ISO/IEC 27034,CSA STAR V4,SOC 2 Type2,德国C5等,满足全球客户业务合规和隐私保护要求。【产业共享】参与和主导制定10+云安全相关标准,输出30+安全白皮书,向产业和客户共享华为安全优秀实践经验。【安全保障】专业的安全运营团队,7*24小时安全保障体系,防御针对云平台的攻击,实现99.99%的安全事件自动响应,让企业上云安全无忧。

-

漏洞名称 : Apache Log4j2远程代码执行漏洞组件名称 : Apache Log4j2影响版本 : 2.0 ≤ Apache Log4j <= 2.15.0-rc1漏洞类型 : 远程代码执行利用条件 :1、用户认证:不需要用户认证2、前置条件:默认配置3、触发方式:远程综合评价 : <综合评定利用难度>:容易,无需授权即可远程代码执行。<综合评定威胁等级>:严重,能造成远程代码执行。漏洞分析:1、组件介绍Apache Log4j2是一款Java日志框架,是Log4j 的升级版。可以控制每一条日志的输出格式。通过定义每一条日志信息的级别,能够更加细致地控制日志的生成过程。2、漏洞描述2021年12月9日,深信服安全团队监测到一则Apache Log4j2组件存在远程代码执行漏洞的信息,并成功复现该漏洞。漏洞威胁等级:严重。该漏洞是由于Apache Log4j2某些功能存在递归解析功能,攻击者可利用该漏洞在未授权的情况下,构造恶意数据进行远程代码执行攻击,最终获取服务器最高权限。影响范围:Apache Log4j2广泛地应用在中间件、开发框架、Web应用中。漏洞危害性高,涉及用户量较大,导致漏洞影响力巨大。目前受影响的Apache Log4j2版本:2.0 ≤ Apache Log4j <= 2.15.0-rc1解决方案:1、如何检测组件系统版本打开项目的pom.xml文件,查看log4j-core的version字段2、官方修复建议当前官方已发布最新版本,建议受影响的用户及时更新升级到最新版本。链接如下:https://github.com/apache/logging-log4j2/releases/tag/log4j-2.15.0-rc2

-

漏洞名称 : Apache JSPWiki 任意文件删除漏洞组件名称 : Apache JSPWiki影响范围:Apache JSPWiki < 2.11.0漏洞类型 : 远程代码执行利用条件 :1、用户认证:不需要用户认证2、前置条件:默认配置3、触发方式:远程综合评价 : <综合评定利用难度>:容易,无需授权即可删除任意文件。<综合评定威胁等级>:高危,能造成任意文件删除。漏洞分析:1、组件介绍Apache JSPWiki 是一个用Java和JSP编写的开源 WikiWiki 引擎,功能丰富,围绕标准 JEE 组件(Java、servlet、JSP)构建。JSPWiki 是一个简单的 WikiWiki 克隆。WikiWiki 是一个允许任何人参与其开发的网站。JSPWiki 支持所有传统的 wiki 功能,以及使用 JAAS 的非常详细的访问控制和安全集成。2、漏洞描述2021年11月30日,监测到一则Apache JSPWiki 组件存在文件删除漏洞的信息,漏洞编号:CVE-2021-44140,漏洞威胁等级:高危。该漏洞是由于未对用户的输入做合适的过滤,攻击者可利用该漏洞在未授权的情况下,构造恶意数据执行任意文件删除攻击,最终造成服务器上任意位置的文件被删除。影响范围:Apache JSPWiki 由于其跨平台和安全性被广泛使用,可能受漏洞影响的资产分布于世界各地,今年曝出的漏洞评分高危,漏洞影响力还是很大。目前受影响的 Apache JSPWiki 版本:Apache JSPWiki < 2.11.0解决方案:1 官方修复建议当前官方已发布最新版本,建议受影响的用户及时更新升级到最新版本。链接如下:https://jspwiki-wiki.apache.org/Wiki.jsp?page=Downloads参考链接:https://nvd.nist.gov/vuln/detail/CVE-2021-44140

推荐直播

-

华为开发者空间玩转DeepSeek

华为开发者空间玩转DeepSeek2025/03/13 周四 19:00-20:30

马欣 山东商业职业技术学院云计算专业讲师,山东大学、山东建筑大学等多所本科学校学生校外指导老师

同学们,想知道如何利用华为开发者空间部署自己的DeepSeek模型吗?想了解如何用DeepSeek在云主机上探索好玩的应用吗?想探讨如何利用DeepSeek在自己的专有云主机上辅助编程吗?让我们来一场云和AI的盛宴。

即将直播 -

华为云Metastudio×DeepSeek与RAG检索优化分享

华为云Metastudio×DeepSeek与RAG检索优化分享2025/03/14 周五 16:00-17:30

大海 华为云学堂技术讲师 Cocl 华为云学堂技术讲师

本次直播将带来DeepSeek数字人解决方案,以及如何使用Embedding与Rerank实现检索优化实践,为开发者与企业提供参考,助力场景落地。

去报名

热门标签